XGBoost回归

# 1、作用

XGBoost 是 GBDT 的一种高效实现,和 GBDT 不同,xgboost 给损失函数增加了正则化项;且由于有些损失函数是难以计算导数的,xgboost 使用损失函数的二阶泰勒展开作为损失函数的拟合。

# 2、输入输出描述

输入:自变量 X 为 1 个或 1 个以上的定类或定量变量,因变量 Y 为一个定量变量。

输出:模型输出的结果值及模型预测效果。

# 3、案例示例

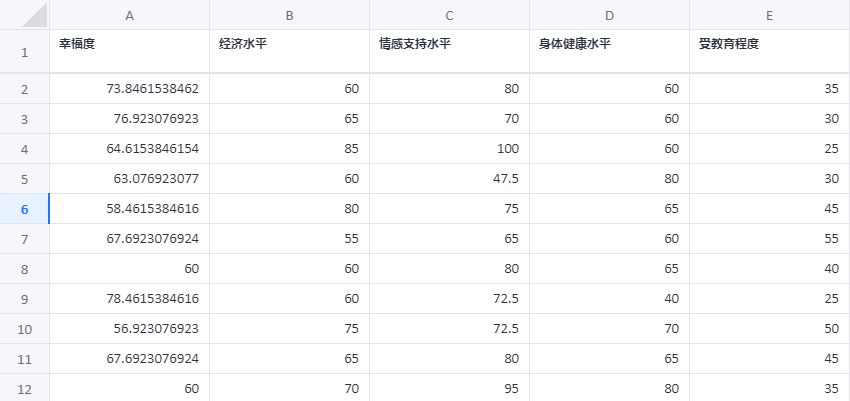

研究“幸福感”的影响因素,有四个变量可能对幸福感有影响,他们分别是:经济收入、受教育程度、身体健康、情感支持。建立 xgboost 模型来预测幸福度。

# 4、案例数据

xgboost 回归案例数据

# 5、案例操作

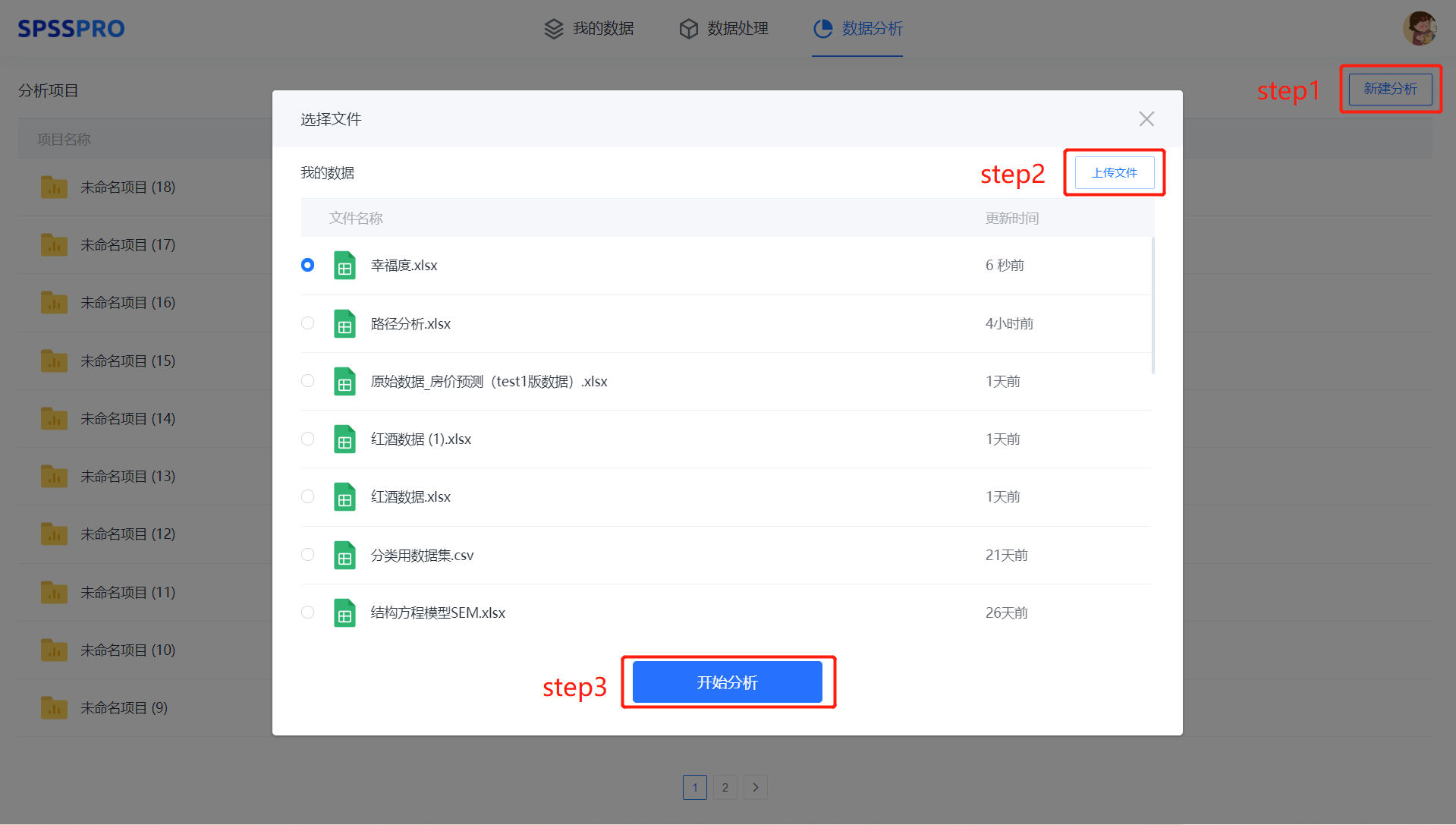

Step1:新建分析;

Step2:上传数据;

Step3:选择对应数据打开后进行预览,确认无误后点击开始分析;

step4:选择【xgboost 回归】;

step5:查看对应的数据数据格式,按要求输入【xgboost 回归】数据;

step6:进行参数设置(“更多设置”里的参数在客户端可进行设定)

step7:点击【开始分析】,完成全部操作。

# 6、输出结果分析

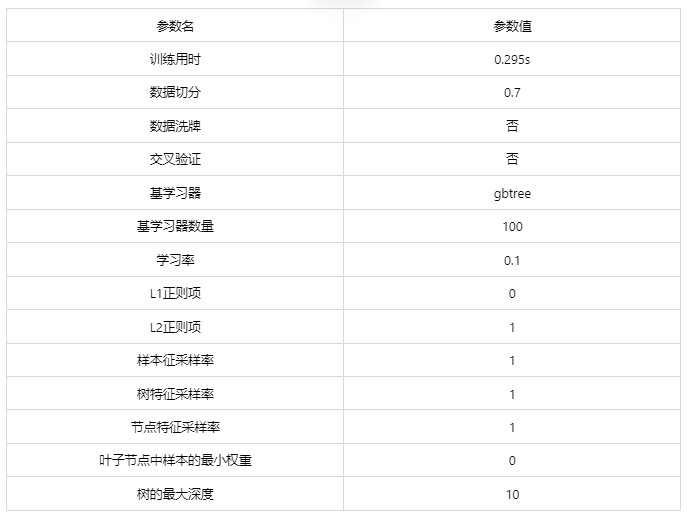

输出结果 1:模型参数

图表说明: 上表展示了训练该模型的时候,输入的参数以及训练所耗的时间。

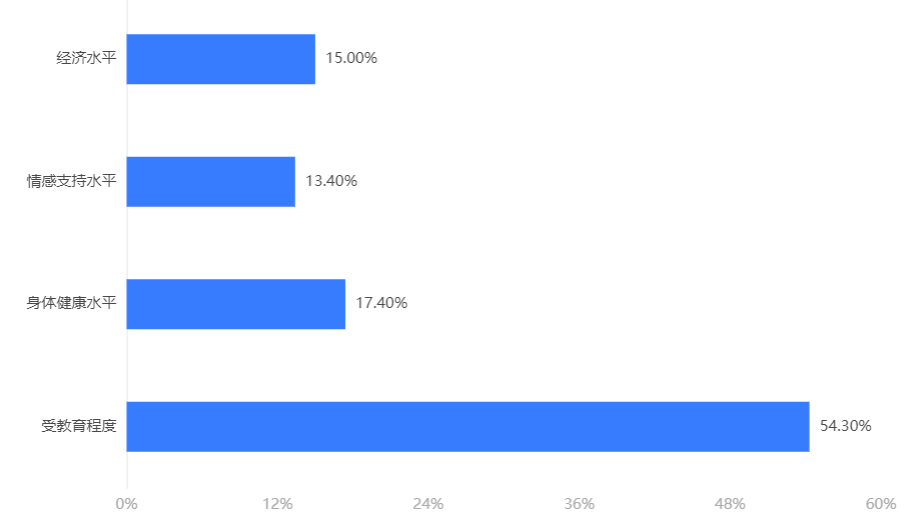

输出结果 2:特征重要性

图表说明:上柱形图或表格展示了各特征(自变量)的重要性比例。(附:有时候可以利用特征重要性反推该变量在实际生活中的价值,因为该重要性往往决定分类结果。)

分析:xgboost 模型中决定分类结果的重要因素是受教育程度。

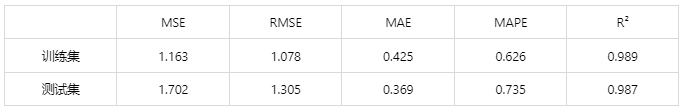

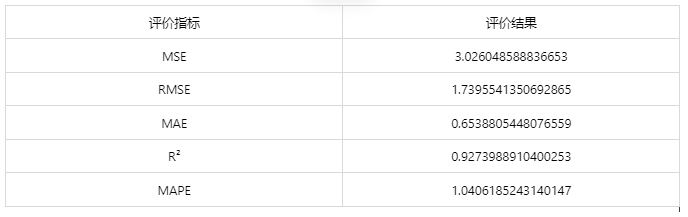

输出结果 3:模型评估结果

图表说明: 上表中展示了交叉验证集、训练集和测试集的预测评价指标,通过量化指标来衡量 XGBoost 的预测效果。其中,通过交叉验证集的评价指标可以不断调整超参数,以得到可靠稳定的模型。

● MSE(均方误差): 预测值与实际值之差平方的期望值。取值越小,模型准确度越高。

● RMSE(均方根误差):为 MSE 的平方根,取值越小,模型准确度越高。

● MAE(平均绝对误差): 绝对误差的平均值,能反映预测值误差的实际情况。取值越小,模型准确度越高。

● MAPE(平均绝对百分比误差): 是 MAE 的变形,它是一个百分比值。取值越小,模型准确度越高。

● R²: 将预测值跟只使用均值的情况下相比,结果越靠近 1 模型准确度越高。

分析:训练集中 R 方为 0.989,测试集中为 0.987,拟合效果优秀。

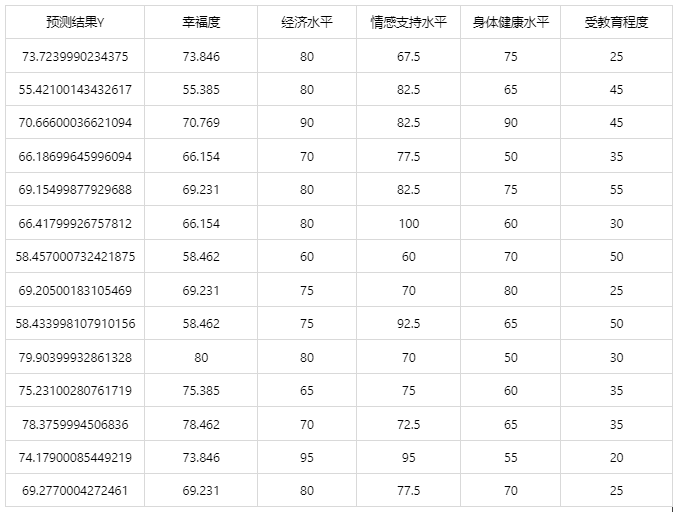

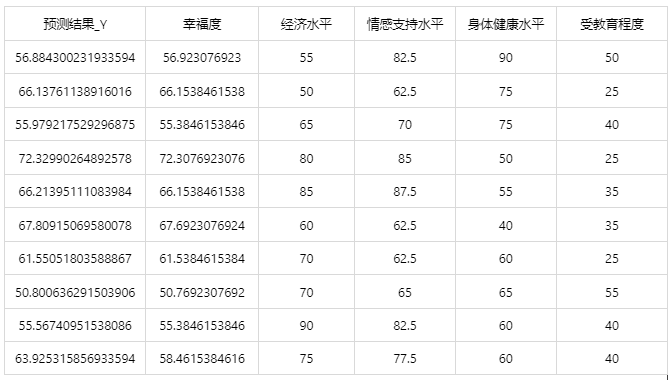

输出结果 4:测试数据预测评估结果

图表说明: 上表格为预览结果,只显示部分数据,全部数据请点击下载按钮导出。

上表展示了 xgboost 模型对测试数据的分类结果,第一列是预测结果,第二列是因变量真实值。

输出结果 5:测试数据预测图

图表说明:上图中展示了 XGBoost 对测试数据的预测情况。由图可知,真实值与预测值十分接近,说明训练出来的 xgboost 模型在测试集上预测效果极好。

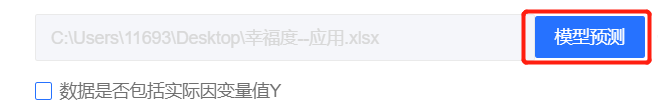

输出结果 6:模型预测与应用(此功能只在客户端支持使用)

注:当无法进行预测功能时,可检查数据集中是否存在定类变量或者缺失值:

● 当存在定类变量时,请在用于训练模型的数据集和用于预测的数据集中将变量编码,再进行操作。

(SPSSPRO:数据处理->数据编码->将定类变量编码为定量)

● 当用于预测数据的数据集中存在缺失值时,请删去缺失值再进行操作。

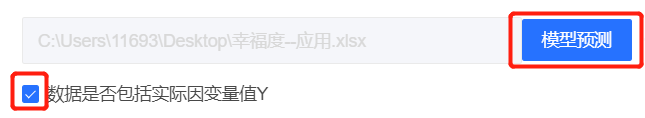

情况 1:在上面模型评估后,模型分类结果较好,具有实用性,这时我们将该模型进行应用。点击【模型预测】上传文件可以直接得到预测结果。

经上述操作后,得到以下结果:

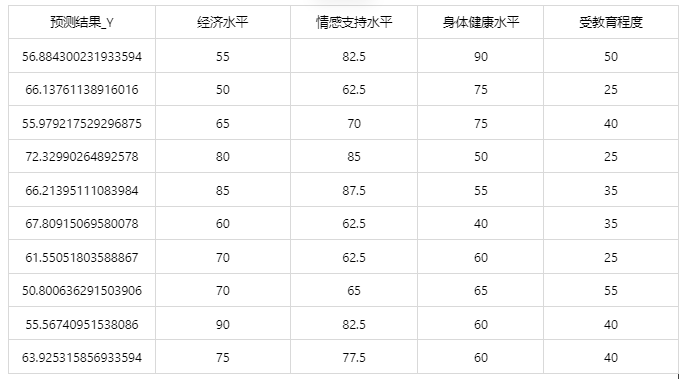

情况 2:若是上传的数据包括因变量真实值,不仅仅可以得到预测结果,还可以得到当前应用数据预测评估效果。

经上述操作后,得到以下结果:

# 7、注意事项

- 由于 xgboost 具有随机性,每次运算的结果不一样。若需要保存本次训练模型,需要使用 SPSSPRO 客户端进行。

- xgboost 的参数修改需要使用 SPSSPRO 客户端进行。

# 8、模型理论

XGBoost 是"极端梯度上升"(Extreme Gradient Boosting)的简称,XGBoost 算 法是一类由基函数与权重进行组合形成对数据拟合效果佳的合成算法。由于 XGBoost 模型具有较强的泛化能力、较高的拓展性、较快的运算速度等优势, 从2015年提出后便受到了统计学、数据挖掘、机器学习领域的欢迎。

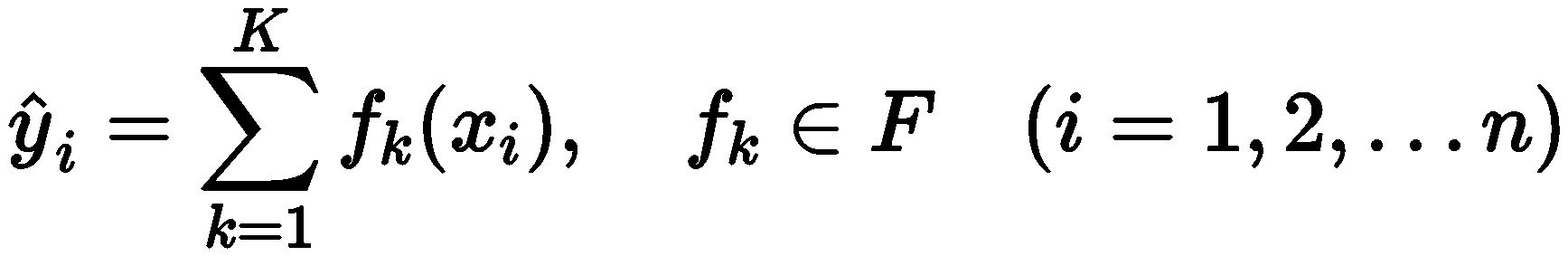

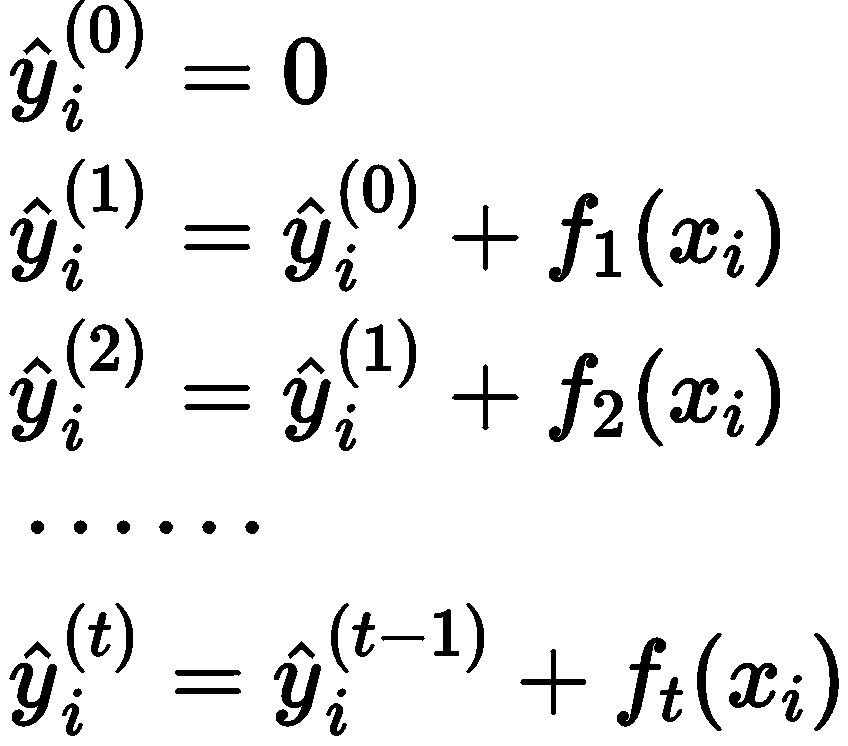

对于包含 n 条 m 维的数据集 , XGBoost 模型可表示为:

![]()

其中:

在使用训练数据对模型进行优化训练时,需要保留原有模型不变,加入一个 新的函数 f 到模型中,使目标函数尽可能大的减少,具体过程为:

其中:

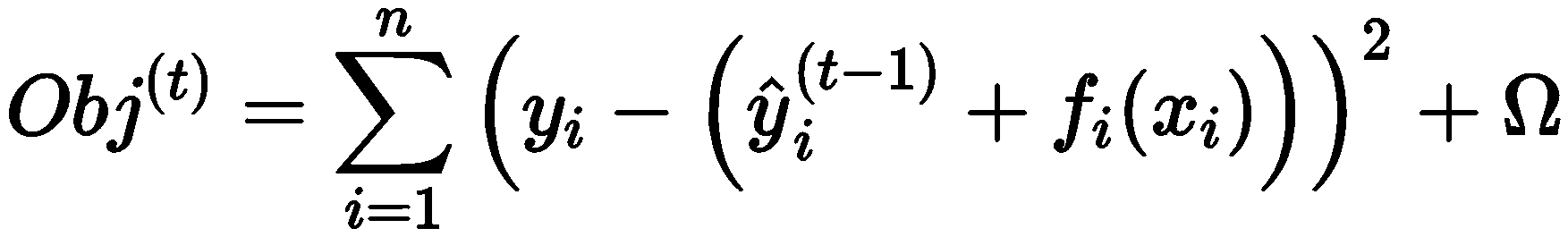

在 XGBoost 算法中,为快速寻找到使目标函数最小化的参数,对目标函数 进行了二阶泰勒展开,得到近似目标函数

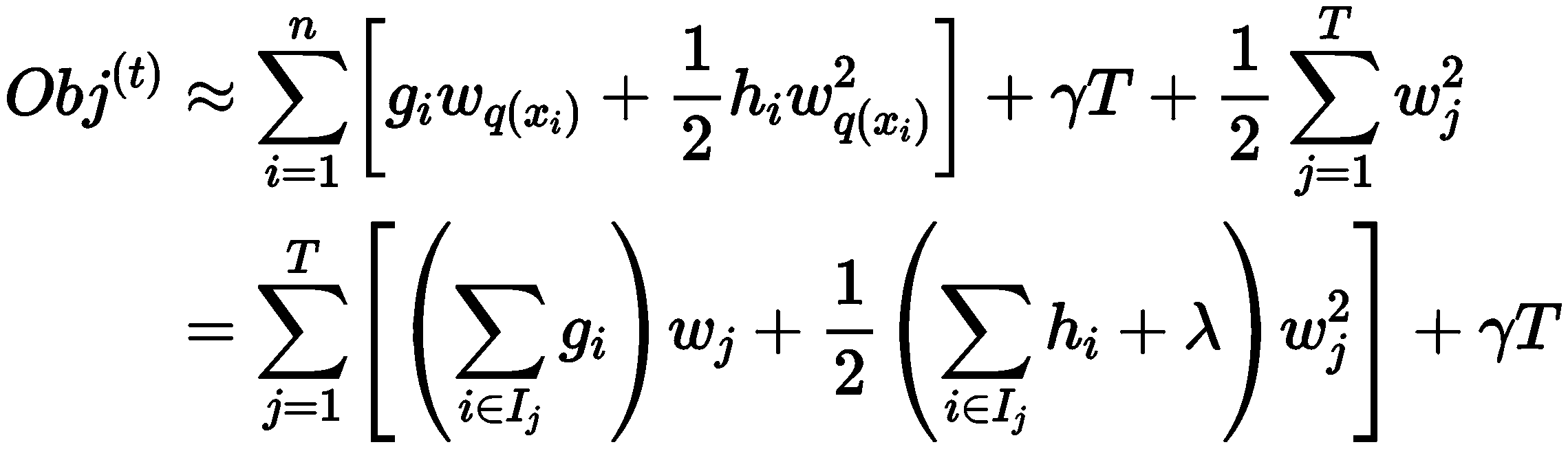

当去掉常数项后可知:目标函数仅仅与误差函数的一阶和二阶导数相关。此时,目标函数表示为:

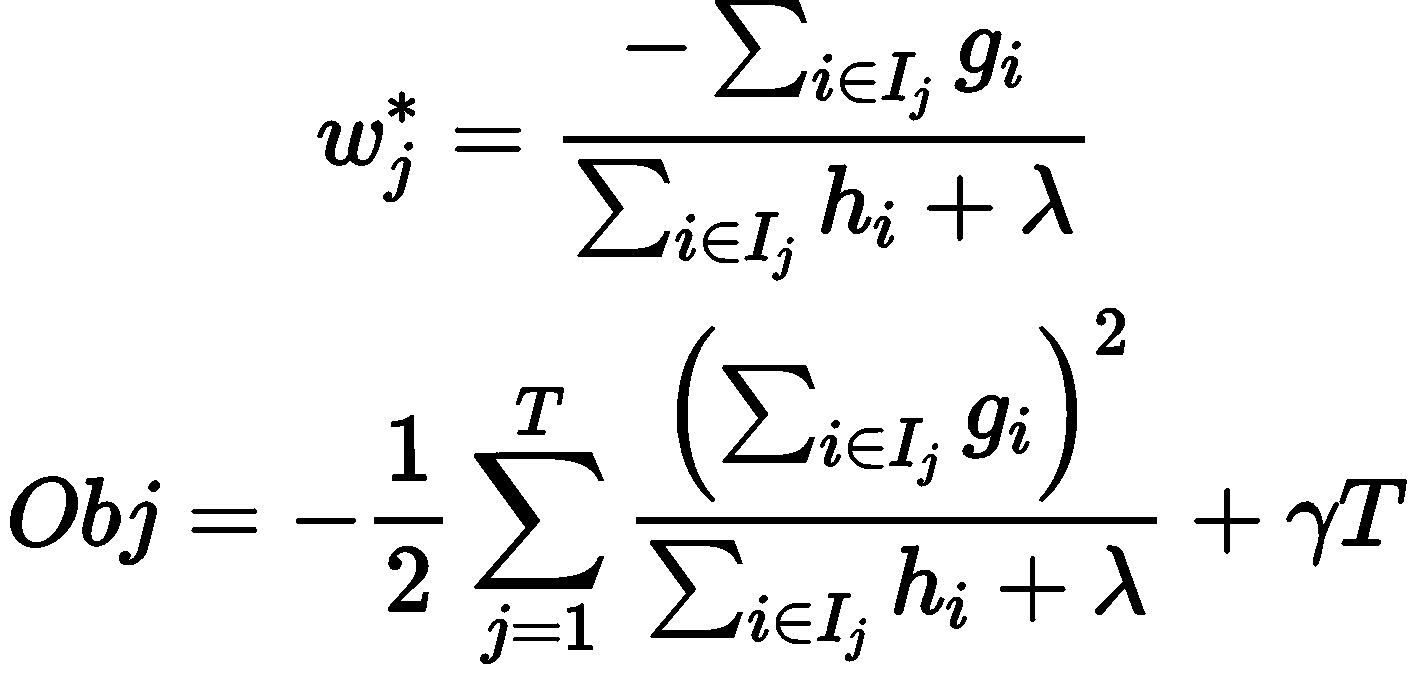

若树的结构部分 q 已知,可使用目标函数寻找最优 Wj,并得到最优目标函数值。其本质可归为二次函数的最小值求解问题。解得:

Obj 是可作为评价模型的打分函数, Obj 值越小则模型效果越好。 通过递归调用上述树的建立方法,可得到大量回归树结构,并使用 Obj 搜索 最优的树结构,将其放入已有模型中,从而建立最优的 XGBoost 模型。

# 9、参考文献

[1]Scientific Platform Serving for Statistics Professional 2021. SPSSPRO. (Version 1.0.11)[Online Application Software]. Retrieved from https://www.spsspro.com.

[2]Chen T , Guestrin C . XGBoost: A Scalable Tree Boosting System[J]. ACM, 2016.